Deep fake-video kan være et værktøj – eller et våben

ANALYSE En deep fake er en video, der viser noget, som aldrig er foregået i virkeligheden, men ligner til forveksling. Der er bekymring over, at de stadig bedre programmer til at forfalske video kan underminere tilliden til medierne og føre til politiske kriser. Men er verden ikke allerede så digital, at det dårlig nok giver mening at skelne mellem ”virkelig” og ”kunstig”?

Det var billedet af prins Andrew med armen rundt om en mindreårig pige, der beseglede hans skæbne. Vi har allesammen set det lidt udvaskede foto af de to. I baggrunden står Ghislaine Maxwell, der nu er anklaget for at have organiseret en jævn strøm af unge piger til milliardæren Jeffrey Epstein. Billedet er stort set så klart et bevis på, at prinsen var del af Epsteins seksuelle affærer, som man kunne ønske.

I et interview med BBC hævder prins Andrew selv, at billedet er falsk: ”Jeg kan kende mig selv, men om det er min hånd … Jeg har ingen erindring om, at det foto nogensinde er blevet taget. Man kan ikke bevise, om det er fake, for det er et foto af et foto af et foto.”

Pointen her er ikke at afgøre, om det var prins Andrews hånd eller ej, men at påpege, hvor stor betydning et kompromitterende foto kan have. For hvad nu, hvis billedet faktisk er fake?

Det ville være en meget effektiv måde at komme ham til livs på.

Vi stoler på billeder – og vi stoler endnu mere på video, men fremover skal vi lære at tage det, vi ser, med større forbehold. Mange mener, at det kun er et spørgsmål om tid, før vi vil opleve, at en stor politisk krise bliver udløst af en deep fake-video, der cirkulerer på de sociale medier.

Der er allerede eksempler på, at manipulation med video bruges meget bevidst i politik.

Ved en pressekonference i Det Hvide Hus forsøgte en assistent at tage mikrofonen fra CNN’s korrespondent, da han stillede nærgående spørgsmål. Efterfølgende delte Trump selv en video online, hvor det øjeblik, journalisten holder hånden op for at afværge assistenten, er speedet op, så det ser ud, som om han er meget aggressiv. Videoen blev brugt til at retfærdiggøre, at man en overgang fratog CNN adgang til briefingerne i Det Hvide Hus.

|

Med den russiske FaceApp kan man more sig med at se, hvordan man selv eller en anden person vil se ud som langt yngre eller langt ældre. |

Vi faker selv rutinemæssigt

Langt mere avancerede måder at bearbejde billeder og video på er på vej, og de bliver stadig mere realistiske og svære at afsløre. Men i langt de fleste tilfælde vil teknologien til at manipulere billeder blive set som et nyttigt værktøj – snarere end et potentielt farligt våben.

”Syntetisk video”, som det også kaldes, vil først og fremmest være en teknologi, der gør det lettere og billigere at lave interessant indhold i medierne, og de færreste vil være forargede over at blive præsenteret for video, som ikke er optaget ”i virkeligheden”, men genereret af en computer.

Vi vil vænne os til det, ligesom vi for længst er blevet vant til, at størstedelen af de fotos, vi ser, lige har fået en tur i Photoshop eller gennem et Instagram-filter.

De fleste af os ”faker” såmænd selv rutinemæssigt – eksempelvis når vi præsenterer os selv på de sociale medier. Profilbilleder og postings bliver nøje iscenesat. På Instagram, Snapchat og TikTok er der et større udvalg af ”beauty filtre”, der kan få brugeren til at have makeup på eller få pænere hud, en smallere næse eller større læber, når man poster videoer og selfies.

I de videomøder, som vi deltager i på arbejdet eller til undervisning, foretrækker mange at sløre eller skifte baggrunden ud, så andre ikke kan se det hjemlige rod.

Vi faker også bare for sjov. Der kommer jævnlig nye apps, der gør det muligt at bytte rundt på folks ansigter, få personen i billedet til at se 20 år ældre ud eller indsætte sit eget billede i stedet for stjernen.

Som med så meget andet digitalt sker der en hastig demokratisering: Teknologien bliver bedre, lettere at bruge og tilgængelig som en gratis app for enhver. Vi har fået en flodbølge af ”cheap fakes”; små sjove manipulerede klip, der sendes rundt til vennerne – og af og til går viralt.

Ser man lidt ud i fremtiden, vil mixed reality, sammenblanding af virkeligt og syntetisk, være den måde, vi oplever verden på. På et eller andet tidspunkt vil augmented reality blive en del af vores standardpåklædning, og mange af os vil gå omkring med et par briller, der lægger grafik eller andre personer ind i billedet – eller ændrer lidt på det, vi ser, eksempelvis som det blev demonstreret i en video for nylig, hvor det ser ud, som om alle, man møder, smiler.

Udseendet, stemmen og bevægelserne kan udskiftes

”Den hypotese, vi bygger vores forretning på, er, at vi altid vil være på rejse mod mere visuelle og mere interaktive former for medier,” siger Victor Riparbelli, CEO og medstifter af Synthesia, et selskab, der udvikler software, som kan bruges til at skabe video, der, som han siger, ”ikke kræver, at der bliver optaget med et kamera”.

Synthesia er oprindelig dansk, men har i dag kontor i London.

I mange af de transaktioner, hvor vi i dag møder et menneske af kød og blod, vil vi fremover kommunikere med en digital skabt figur.

Automatisering og selvbetjening breder sig, og fra den kommunale borgerservice til check-in i lufthavnen, online-shopping eller assistenter som Apples Siri eller Google Assistant vil systemerne møde os med mere eller mindre intelligente chatbots. En stor del af dem vil være manifesteret i form af en person, i en billedkvalitet, der er svær at skelne fra en videooptagelse.

Det er her, syntetisk video kommer ind i billedet. Synthesia og andre selskaber kan analysere video og lydoptagelser og uddrage karakteren af en persons udseende og stemme. Det kan bruges i forskellige kombinationer til at producere video:

- Man kan overføre ansigtsudtryk og mundbevægelser til en person i en video – lidt som om man ville styre en marionetdukke. Ved at ændre mundbevægelserne kan man tilpasse dem, så det ser naturligt ud, når personen siger noget

- Når man har uddraget karakteren af en persons stemme, kan man få læst tekster op med vedkommendes stemme – og mundbevægelserne på personen i den kunstige video kan synkroniseres med det, der læses op.

Kunstige tv-værter og fotomodeller

Synthesia bruger den teknologi til at tilbyde fotorealistiske syntetiske tv-værter.

Undervisning og intern kommunikation er et stort marked. Internationale selskaber skal ofte instruere eller orientere medarbejdere i mange lande og på mange forskellige sprog om de samme emner. Med syntetisk video kan man indspille undervisningsmateriale og få personen i billedet til at fortælle på et hvilket som helst sprog.

Samme fremgangsmåde kan bruges til at lave forskellige versioner af reklamer. Et eksempel er en reklame, hvor David Beckham fortæller om Malaria på ni forskellige sprog.

En anden anvendelse kan være automatiske nyheder – eksempelvis en tv-station, der vil automatisere oplæsningen af vejrudsigten. Man skriver blot den tekst, der skal læses op af den automatiske tv-vært – der til forveksling ligner stationens virkelige tv-vært.

Der findes allerede robotter, der automatisk kan generere tekster baseret på standardiserede data, eksempelvis om vejret, børskursernes udvikling eller sportsresultater. Med en syntetisk vært kan den type data præsenteres på en lidt mere interessant og menneskelig måde. Det gør det naturligvis også langt billigere at skabe indhold, der konstant er opdateret eller versioneret til et meget specifikt lokalt område.

Som kunde kan man få lavet en digital udgave af den person, man ønsker at bruge som vært. Det kunne være en populær tv-vært eller virksomhedens direktør. Man kan også blot benytte en af de standardpersoner, fra et galleri af oplæsere, som Synthesia har produceret.

Det amerikanske modelbureau Rosebud har et katalog på 25.000 kunstigt skabte modeller af mennesker, der ser ud, som om de var virkelige. Modellerne kan bruges som mannequiner til at vise tøj.

|

På websitet Rosebud.ai kan man mikse sig frem til den model, man ønsker at bruge. Man vælger køn, etnicitet, hår, ansigtsudtryk, baggrund osv. og resultatet er et fuldstændig realistisk foto af en person som aldrig har eksisteret. |

Enhver vil kunne lave en Hollywood-film

Det er, hvor vi er i dag. Fremover vil realismen af billederne blive forbedret, og de syntetiske videofigurer vil kunne styres, så det ikke kun er små bevægelser som munden, men hele kroppen, der kan styres, og så personen kan dreje sig og bevæge sig gennem et sceneri, samtidig med at skygger og refleksioner i omgivelserne tilpasses.

”Vores vision er, at alle om ti år fra deres laptop kan lave, hvad der svarer til en Hollywood-film,” siger Victor Riparbelli.

”Forestil dig, at du sidder og tegner en tændstikmand og bestemmer, hvor den skal gå hen – og så gør den det. I dag skal du programmere alt, hvad computere gør, men med kunstigt intelligent software vil man kunne tage en simpel skitse og lave det om til noget, der er svært at skelne fra rigtig video.”

”Hvis du vil ændre en persons hårfarve i dag, er du nødt til at fortælle computeren, hvilke pixels den skal ændre. Maskinen aner ikke, hvad hår eller et menneske er. Men i fremtiden, når du lukker et billede op, så forstår computeren, hvad den ser. Den ved, hvad der er hår, øjne, hænder osv. Så du beder den bare skifte hårfarve. Du behøver ikke at kunne håndværket eller at gøre en kunstnerisk indsats for at det fungerer,” siger Victor Riparbelli.

Hollywood-film er for længst blevet en blanding af virkelige og computerskabte skuespillere. I en kommende film om Vietnamkrigen – Finding Jack – skal James Dean, der døde i 1955, medvirke i flere scener.

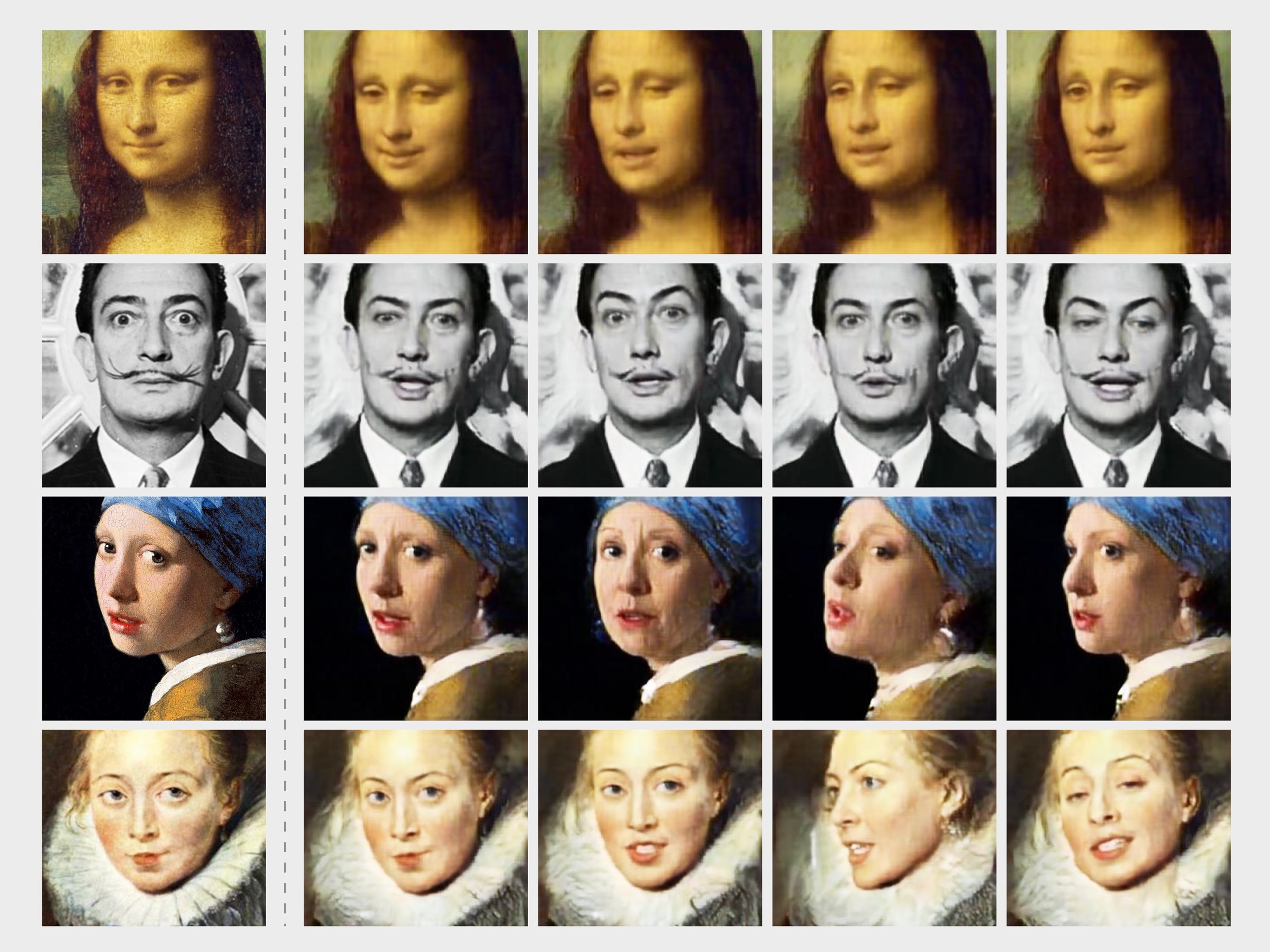

|

Samsungs AI lab i Moskva har overført en skuespillers bevægelser for at bringe afdøde berømtheder til live i nye videoer. Endelig kan Mona Lisa gøre andet at smile skævt. |

Software kan afsløre manipulation

Defudger, en anden dansk startup med internationale ambitioner, arbejder stort på det modsatte af Synthesia. Defudger udvikler software, der kan analysere og afsløre tegn på, at video og fotos er manipuleret.

”Vi har igennem århundreder kunnet stole på visuelt indhold, men nu er det meget sværere at gennemskue, hvad der er sandt og falsk. Det er blevet så nemt og hurtigt at manipulere, at det er en trussel mod demokratiet og ytringsfriheden,” siger Dominik Mate Kovacs fra Defudger.

Teknologien viser sin mørke side, når nogen bruger den til bevidst at fordreje og narre andre til at tro på noget vigtigt, der overhovedet ikke er sandt.

Første gang udtrykket deep fake blev brugt, var for at beskrive en genre af videoklip på internettet, hvor kendte skuespillerinders ansigt bliver indsat i en pornofilm. Men falske videoer kan potentielt anrette langt større skader.

Vi ser jævnligt eksempler på, at videooptagelser udløser demonstrationer eller vælter regeringer.

- Sidste år måtte en østrigsk minister gå af, efter at han på skjult kamera blev lokket til at modtage bestikkelse fra en russisk rigmand

- Den nylige video af politiets drab på George Floyd i Minneapolis udløste store uroligheder og satte skub i Black lives Matter-bevægelsen.

Selvsagt er det afgørende, at så kontroversielle videoer er autentiske. Defudger arbejder sammen med flere medieselskaber, blandt andet den tyske Springer-koncern, der har et indlysende behov for at vide, om det, de viderebringer i deres medier, er virkeligt.

Defudgers teknologi kan imidlertid bruges til at afsløre mere dagligdags svindel – eksempelvis i forsikringssager.

”Folk sender billeder af deres bil, der er gået i stykker, eller af skader, der er sket på deres ejendom, og det er nødvendigt at vide, om billederne er ægte eller manipulerede. Det har især været vigtigt under coronakrisen, hvor inspektørerne ikke har kunnet tage ud at kontrollere hos anmelderne af skader,” fortæller Dominik Kovacs.

Defudger understøtter også analyse af de fotos af id-papirer, som folk indsender til myndigheder eller banker, når kontrakter bliver indgået online. Defudger blev stiftet i 2019 af tre studerende på DTU – alle fra Ungarn. I dag er der syv ansatte, fordelt på kontorer i København, Berlin og i USA.

|

Deep fakes florerer på de sociale medier. Det kan være ganske underholdende – eller ganske farligt |

The medium or the message

Der har været manipulation længe før digital teknologi. Selv i dag er mange af de fakes, der cirkulerer, relativt simple rent teknisk.

Betegnelsen ”shallow fakes” – overfladiske forfalskninger – bruges sommetider, når det er ganske enkle midler, der er brugt til at manipulere.

I Indien førte det til sammenstød mellem hinduer og muslimer, da der på Whatsapp cirkulerede billeder af døde børn fra et nervegasangreb i Syrien. Billederne blev brugt til at underbygge falske påstande om kidnapninger.

Der skal ikke så meget til for at narre, især ikke, hvis folk gerne vil narres.

Som Victor Riparbelli udtrykker det, må man skelne mellem the medium og the message – mellem mediets virkemidler og det, der bliver fortalt med dem:

”Ja, man kan sagtens lave en video, hvor Trump eller Putin siger noget, der kan provokere. Men man kan også tage Socialdemokratiets partiprogram og formidle det på en mere interessant måde, der gør noget relevant stof lettere tilgængeligt for flere. Det afgørende er, hvad man vil opnå som afsender – snarere end måden, man gør det på,” mener Victor Riparbelli.

Ankeret trækkes op, så sandt og falsk flyder

Linjerne mellem syntetisk og autentisk vil udviskes yderligere fremover, og man kan overveje, om det i længden overhovedet giver mening at forsøge at skelne mellem det, vi oplever fysisk, og det, der er virtuelt.

Hvad gør det ved os, hvis vi begynder at opfatte det, vi ser virtuelt, som lige så virkeligt som det, vi oplever fysisk? Hvis vi dårlig kan gennemskue, hvem det egentlig er, vi snakker med, hvem det er, vi omgås, og hvem der er afsenderen af de budskaber, vi modtager?

Vi er fysiske væsener, vi har i hele vores eksistens som art styret efter fysiske signaler. Når vi så noget på urtidens savanne, var det sandt. I dag skal vi handle på signaler, der er kunstige, men hvis betydning ikke desto mindre kan have lige så konkrete konsekvenser som det, vi ser fysisk.

Når man ser på retoucheringer af gamle sort/hvide fotos eller ser de special effects, der tidligere blev brugt i film, ryster man lidt overbærende på hovedet over, at folk virkelig troede på det.

Det moderne menneske er blevet vant til at gennemskue langt mere realistiske fabrikationer. Redigeringen og sammenblandingen med computerskabte elementer er blevet en del af de almindelige sproglige virkemidler. Som modtagere forstår vi, at budskabet godt kan være sandt, selv om de billeder, vi ser, er fuldstændig kunstige.

Men det er et våbenkapløb. Hver gang en teknologi muliggør, at et nyt aspekt af virkeligheden kan manipuleres, er der en periode, hvor mange modtagere ikke er opmærksomme på, at det, de ser, kan være forfalsket.

Med deep fake-videoer bliver ankeret trukket op, og hvad der er sandt og falsk, flyder. Vi mister nogle af de holdepunkter, der hidtil har forankret begreberne for os.