BLOG: Fake news 2.0: Hvad stiller vi op mod digitalt modificerede politikere?

BLOG: En ny generation af falske nyheder kan være på vej med digitale manipulationer af politikere, som siger ting, de aldrig har sagt. Den teknologiske udvikling giver nye muligheder for at forfalske – men også for at afsløre forfalskningerne.

Af Pierre Collignon

Lyden er som klippet ud af en søvnig Twin Peaks-scene. Der er noget forvrænget og plastisk over stemmen, men man genkender Donald J. Trump.

@realDonaldTrump https://t.co/N6DRPdEGPT pic.twitter.com/G30DvmQNdk

— Lyrebird AI (@LyrebirdAi) 4. september 2017

Det er dog ikke USA’s 45. præsident, som taler – men en robot. Vi hører demonstrationen af et produkt, som en canadisk startup, Lyrebird, er ved at udvikle: en digital lydboks, som kan fremtrylle kopier af stemmer og få kopien til at sige hvad som helst. Hvis altså sproget er engelsk, og man kan levere optagelser af stemmen i høj kvalitet.

Pierre Collignon, tidligere chefredaktør på Jyllands-Posten, er i gang med et fellowship på Center for Journalistik, Syddansk Universitet, hvor han undersøger, hvordan fake news og stærkt holdningsprægede medier påvirker nyhedsbilledet. Han skriver løbende om nogle af sine resultater på denne blog på TjekDet.

Pierre Collignon, tidligere chefredaktør på Jyllands-Posten, er i gang med et fellowship på Center for Journalistik, Syddansk Universitet, hvor han undersøger, hvordan fake news og stærkt holdningsprægede medier påvirker nyhedsbilledet. Han skriver løbende om nogle af sine resultater på denne blog på TjekDet.

Blogindlægget er udtryk for skribentens egen holdning.

Jeg har testet Lyrebirds seneste betaversion. Man bliver bedt om at læse 30 sætninger op, så maskinens neurale netværk får noget at arbejde med, og så bør ens stemme-avatar være klar. Der skal dog nok en renere lyd til, end min bærbares mikrofon kunne levere – for hos mig var resultatet uforståelig mumlen.

Noget af det er begyndervanskeligheder, indrømmer folkene bag Lyrebird, men deres digitale lydmaskine bygger på kunstig intelligens (AI), så den vil i teorien blive bedre for hver ny stemmeoptagelse, som føjes til lageret.

Folkene bag Lyrebird mener, at deres teknologi kan bruges til fx at skabe kopier af sygdomsramte menneskers stemme. De siger også, at de lancerer nu for at skabe debat og udbrede kendskab til, at det er muligt at fremstille digitale kopier af folks stemmer, så samfundet kan reagere på det og tilpasse sig.

Barack Obama siger noget, han aldrig har sagt

Firmaet understreger i en blogpost om etik, at det ikke vil lade nogen bruge andre menneskers stemme uden deres udtrykkelige tilladelse, men teknologien har naturligvis fantastisk potentiale til forfalskning. Lyrebird har selv produceret en video, hvor en cyber-udgave af Barack Obama reklamerer for deres ”cool startup”.

Lyrebird har ikke villet svare på, om de har fået Barack Obamas tilladelse til at bruge hans stemme, men de har de næppe. De skriver på YouTube, at Obamas kunstigt skabte budskab ikke repræsenterer hans holdninger.

Lyrebirds unge grundlæggere står ikke alene med bud på, hvordan man kan manipulere med lyd og video. Der er en rivende udvikling i gang inden for kunstig intelligens, Machine Learning og en ny generation af 3D-grafik, og det kan kun være et spørgsmål om tid, før de nye muligheder også påvirker udbuddet af falske nyheder.

Fake news 1.0 – som fortsat er dem, vi mest støder på – bygger på tekst. Det er opdigtede historier skrevet som nyhedsartikler med rubrikker som ”Pave Frans chokerer verden: støtter Trump som USA’s præsident” eller ”WikiLeaks BEKRÆFTER: Hillary solgte våben til IS”. Den slags historier, vi lærte at kende under det amerikanske præsidentvalg i 2016. Manipulationen er først og fremmest en low-tech udnyttelse af clickbait-journalistikkens værste tricks.

Vi kender også til, at billeder sættes sammen med falske udsagn eller citater i memes, der deles på sociale medier. Der er talrige eksempler på, at billeder eller video tages ud af deres kontekst for at blive bragt i en ny, falsk forbindelse – for eksempel om troppebevægelser eller overgreb i krigszoner, hvor digitale efterforskere nogle gange må bruge dage på at undersøge et videoklip, før de kan konkludere, om oplyste tid og sted kan passe.

Fake news er nogle gange også direkte manipulationer af billeder eller video. Ved hver stor oversvømmelse dukker utrolige billeder op af hajer på de sociale medier – så utrolige, at de naturligvis er falske.

Believe it or not, this is a shark on the freeway in Houston, Texas. #HurricaneHarvy pic.twitter.com/ANkEiEQ3Y6

— Jason Michael 🦈 (@Jeggit) 28. august 2017

Spørgsmålet er, om vi snart vil se flere og mere avancerede manipulationer af den slags.

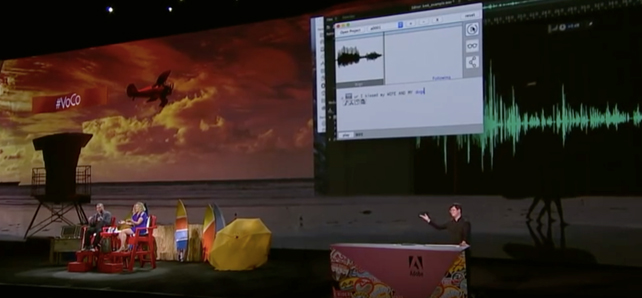

Photoshop vil producere syntetiske stemmer

Den amerikanske softwaregigant, Adobe, som blandt andet er kendt for billedbehandlingsprogrammet Photoshop, er på trapperne med et nyt produkt, VoCo – som ifølge Adobe skal gøre for lyd, hvad Photoshop har gjort for billeder. VoCo vil gøre det muligt at ændre i lydfiler, så man kan retouchere talefejl eller rette i en forkert oplæsning ved at erstatte enkelte ord med andre ord. Det nye er, at man ikke blot klipper i eksisterende lyd. Man skaber et nyt digitalt lydspor, som kan efterligne en rigtig persons stemme - ligesom hos Lyrebird.

Hvis VoCo råder over 20 minutters taletid fra en person, vil programmet være i stand til fremstille en syntetisk kopi af personens stemme og få den til at sige hvad som helst; endda med mulighed for tilvalg af forskellige følelser og betoninger i stemmen.

Adobe præsenterede VoCo med stor begejstring sidste år – se videoen her. Den kan både fascinere og skræmme.

Adobe peger selv på, at teknologien kan bruges i filmproduktioner, hvor man efter optagelserne vil kunne rette i en skuespillers replikker. Men det er oplagt, at VoCo også vil kunne bruges til at fabrikere fake news.

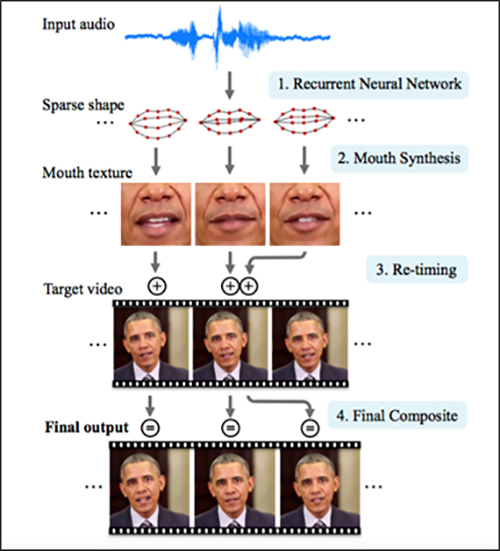

Udviklingen på videosiden er også spændende. Man kan allerede i dag producere videoer, som viser Barack Obama holde en tale, han aldrig har holdt. Det samme kunne gøres med den danske statsministers nytårstale, hvor manipulationen hjælpes på vej, fordi personen ser lige ind i kameraet, og lyset er stabilt.

Barack Obama taler til nationen – eller gør han? Se videoen her.

En gruppe forskere har præsenteret projektet Face2Face, hvor man kan overtage et andet menneskes ansigtstræk på en video og fremprovokere smil, vendte mundvige, spærrede øjenbryn – eller hvad man nu kan finde på; i realtime. Der er småkiks i billederne, men det er slående at se en tysk it-forsker styre George W. Bush’ mimik uden forsinkelse.

På University of Washington i det nordvestlige USA har forskere i 3D-grafik produceret næsten perfekte, kunstige videoer af folk, som taler, ud fra eksisterende lydfiler og videooptagelser af samme menneske. Eksperimentet er bl.a. udført med taler holdt af USA’s tidligere præsident, Barack Obama. Her var der timer af perfekt materiale i HD-kvalitet til rådighed fra Obamas ugentlige taler til nationen.

Forskerne forklarer, at de håber, at deres teknologi kan bruges til at forbedre kvaliteten af billedsiden på videosamtaler over fx Skype, og de understreger i en pressemeddelelse, at de ”aldrig ville gå ned ad det spor at lægge andre menneskers ord i munden på nogen”.

Teknologien er guf for leverandører af falske nyheder

Barack Obamas digitalt fremstillede mundbevægelser er imidlertid så realistiske, at man ikke behøver stor fantasi for at forestille sig, hvad fake news-operatører kunne gøre med teknologien. Det er bare at kombinere med skabelsen af en syntetisk lydfil fra VoCo eller Lyrebird, og så har man en 100 pct. fabrikeret tale, der ligner den ægte vare.

Syntetisering af Obama skridt for skridt – figur fra en forskningsartikel om projektet.

De nye teknologier kan udfordre vores opfattelse af lyd og video. Banker bruger i dag kunders stemmer for at sikre identifikation over telefonen, og i retssale verden over er lyd og film ofte afgørende bevismateriale, men med de nye teknologiers fremmarch vil der oftere opstå tvivl om validiteten af lyd og video. Og ligesom falske nyheder forvirrer så meget, at de skaber tvivl om rigtige nyheder, kan selve eksistensen af de nye manipulationsteknikker også få folk til at betragte alle slags lyd og video med større mistro.

Et eksempel: I oktober 2016 skabte en lydoptagelse af Donald Trump skandale. På lydfilen kunne man høre Trump tale nedsættende om kvinder og bl.a. slå fast, at man bare skulle ”grab ’em by the pussy” (tage dem i skridtet), men havde VoCo været på markedet, kunne man forestille sig, at Trump havde råbt ”FAKE NEWS” og påstået, at optagelsen var fup.

Vi er altså på vej ind i en tidsalder med mulighed for allestedsnærværende forfalskninger af virkeligheden og risiko for større forvirring end nogensinde.

Men inden vi forfalder til teknologipessimisme, skal vi vide, at der findes en stribe teknologiske modsvar. Nogle af dem kan endda blive udviklet af de samme mennesker, som står bag manipulationsteknologierne:

· Adobe har lovet, at lydmanipulation foretaget i VoCo vil blive forsynet med et digitalt vandmærke, så man kan se, at der er foretaget en digital bearbejdning.

· Face2Face-holdet arbejder sideløbende med deres digitale overtagelser af ansigter på teknikker, som skal gøre det muligt at afsløre digital manipulation automatisk, siger Justus Thies, en af forskerne bag Face2Face (det er ham, som overtager George W. Bush’ mimik på demonstrationsvideoen). Han forestiller sig, at filtre mod manipuleret indhold en dag kan blive en del af sociale mediers algoritmer. Justus Thies foreslår også at involvere producenter af kameraer. De kan indlejre krypterede mærker i billedfiler, som så skal valideres af modtageren ved hjælp af en nøgle.

· Nyheds- og indholdsbureauer som Associated Press og Storyful har det allerede som produkt på hylden, at de validerer brugergenereret indhold fra sociale medier ved for eksempel at tjekke oplysninger om tid, sted og personer. AP har indledt et samarbejde med Google for at automatisere den proces, og det vil være en oplagt forretningsmulighed at udbygge det værktøj med nye filtre til opdagelse af digital manipulation.

På samme måde vil flere tunge spillere, også giganter som Facebook og Google, have en interesse i at udvikle metoder til at opfange manipuleret indhold, så brugerne kan kende forskel på ubehandlet og forarbejdet indhold på deres platforme.

Journalister må på teknologisk efteruddannelse

For seriøse nyhedsmedier bliver det en bunden opgave at garantere, at de kun præsenterer genuint indhold. Det skal være tydeligt, at der er forskel på deres indhold og på den malstrøm af junk og fup, som man ellers kan støde på derude.

Nyhedsmedier skal derfor sikre sig grundkompetencer inden for digital forensics, som det digitale efterforskningsfelt hedder. Fra den elementære billedsøgning på nettet (reverse image search) til brugen af Google Earth, Google Street view og billeder fra sociale medier som led i researchen, når man forsøger at verificere historien om et billede eller et videoklip.

Vi skal vænne os til, at vi ikke længere kan nøjes med at have dygtige faktatjekkere, som kan gå politikeres udsagn efter i sømmene. En større del af informationskampen flytter over til mere uofficielle kanaler på sociale medier, hvor det snarere vil handle om verifikation end om faktatjek: Er denne video, der præsenteres som en IS-slavehandel, virkelig en IS-slavehandel – eller er der tale om en iscenesat propagandavideo?

Vi må tro på, at det teknologiske kapløb på feltet vil give os nye værktøjer til at opfange digital manipulation, men vi vil også komme langt med gammeldags sund fornuft. Hvis vi støder på et 20 sekunders klip af en politiker, som udtaler noget helt outreret, så skal vi vurdere kilden, tjekke om andre har filmet det samme, og gerne også se den fulde optagelse, som sekvensen skal være klippet ud af. Simple researchskridt, der kan afsløre mange fupnumre.

Seriøse nyhedsmedier skal også holde fast i de etiske grænser, som de i dag pålægger sig selv i billedbehandling: De bruger kun Photoshop til forsigtig efterbehandling af lys og farver i billeder, og hvis de begiver sig ud i en noget, der reelt skaber en ny virkelighed, skilter de med, at der er tale om en ”collage” eller ”montage”.

Det princip kan vi naturligvis overføre til udfordringen fra fake news 2.0. Det vil sige, at medier klart skal oplyse det, hvis de manipulerer med videoer - for eksempel i satirisk sammenhæng. Varedeklarationen bliver vigtigere end nogensinde, hvis de sociale medier kommer til at svømme over af digitale manipulationer af alt fra hajer til talende politikere. Mareridtsscenariet er, at forvirring og tvivl breder sig til alle informationskilder.

Derfor bliver det en dobbelt udfordring for medierne: De skal både blive gode til at opfange digitale forfalskninger – og til at forklare, at de er gode til det, så mediebrugerne fortsat vil have tillid til de rigtige billeder, videoer og nyheder.

Vil du vide mere?

· Prøv at lytte til denne fremragende podcast fra RadioLab. De har også selv eksperimenteret med at lave en falsk version af Obama.

· Sidste år fremlagte MIT resultater fra et forskningsprojekt, hvor en computer var sat til at forudsige handlingen i små video og selv kreere de manglende sekvenser.

· Hvis du vil lege, så prøv Faceapp – en russiskbygget app, der kan bearbejde dit ansigt, så det fx tilføjes smil eller gøres ældre. Sådan ser det fx ud, når jeg får hjælp af Faceapp til at smile … Mit smil ser godt nok påklistret ud, men husk: Der er tale om et trick udført på to sekunder i bussen på vej på arbejde. De nye manipulationsteknologier er kun ved deres spæde begyndelse.

”Good night, and good luck” … med at kende forskellen på sande og falske nyheder I fremtiden.

Få Mandag Morgens overskrifter direkte i din mail.

Tilmeld dig nyhedsbrevet nu

Mandag Morgen leveres af Mandag Morgen ApS, der ejes af Alrow Media ApS.

Ansv. ChefredaktørAndreas BaumannDirektørAnne Marie KindbergCFOAnders JørningKommerciel direktørMichael ThomsenFormand og udgiverRasmus Nielsen