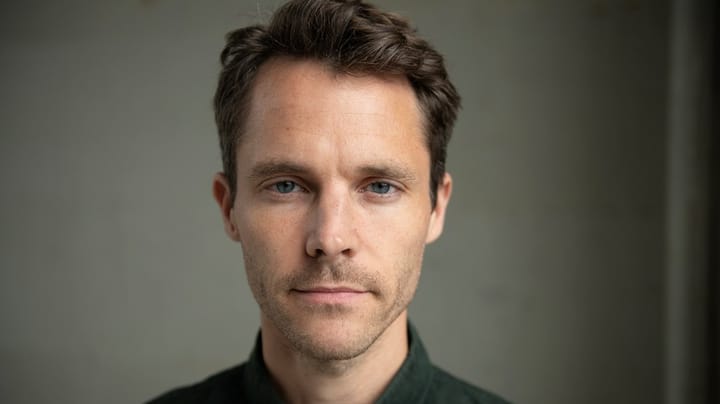

Ansvarshavende chefredaktør på Mandag Morgen og en del af Alrow Medias danske ledelse. Sidder i Advisory Boards for gravercenter.dk på DMJX og Klimasamlingen på KU. Baggrund som undersøgende journalistik indenfor især økonomi og erhverv. Tidligere journalist på Jyllands-Posten, TV2-Nyhederne, Ugebrevet A4, vært og redaktør på P1 Dokumentar, erhvervsredaktør i DR Nyheder, redaktionschef på P1 Morgen og redaktør for et tværeuropæiske graveprojekt om svindel med udbytteskat og dokumentaren 'Mændene, der plyndrede Europa'.Tidl. formand for FUJ-prisens jury. næstformand i Foreningen for Undersøgende Journalistik (FUJ) og censor på journalistuddannelsen på RUC og evalueringspanelet for DMJX.

Måske er det på tide at aktivere Facebooks ’break glass measures’?

Et internt forskerhold på Facebook nøjedes ikke med at dokumentere det sociale medies mange skadevirkninger. De anviste også brugbare løsninger – gemt væk i en værktøjskasse, der fik navn efter det glas, man skal smadre for at komme ind til nødbremsen eller brandalarmen.

Til foråret træder nye regler i kraft, der gør det ulovligt at sælge e-cigaretter med børnelokkende smagsvarianter med frugtduft. Det seneste eksempel på årtiers stadig strammere regulering af sundhedsskadelige produkter, som samfundet særligt ønsker at beskytte børn og unge mod at blive afhængige af.

Ligesom techgiganterne længe har vidst, at deres produkter er skadelige for børn (og os andre), så vidste tobaksindustrien længe før resten af samfundet, at røgvarerne førte til kortere liv og dårligere helbred.

Sammenligningen mellem tobaksindustrien og techindustrien blev brugt i den seneste uges høring i den amerikanske kongres, hvor en whistleblower fortalte om interne studier på Facebook, der blandt andet dokumenterer, at helt unge piger har øget risiko for at komme til at hade deres krop, hvis de er meget på Instagram.

Kunne man forestille sig advarselsskilte på Instagram og forbud mod vanedannende ‘tilsætningsstoffer’ i algoritmen?

Tanja Nyrup Madsen

Chefredaktør, Mandag Morgen

Ingen betvivler i dag myndighedernes ret og pligt til at forbyde tobaksfirmaer at tilsætte indholdsstoffer, der gør cigaretter mere vanedannende. Men, hvis det er uetisk at arbejde målrettet på at gøre sine kunder nikotinafhængige, er det så ikke tilsvarende uetisk at gøre unge mennesker så hooked på likes, hjerter, kommentarer og perfekte kroppe, at de bliver ensomme, deprimerede og selvskadende af det?

KUNNE MAN forestille sig advarselsskilte på Instagram og forbud mod vanedannende tilsætningsstoffer i algoritmen på alle sociale platforme? Og transparens, så offentligheden får indblik i de sociale mediers algoritmers ingredienser og virkning?

De lækkede Facebook-filer fra Wall Street Journal viser, at tanken ikke er så teoretisk, som den kunne lyde. Facebook, der også ejer Instagram, har brugt et årti på at finpudse sine algoritmer, så deres produkter bliver så vanedannende som muligt. Derfor ved techgiganten også, hvad der skal til for at skrue ned for den narkotiske virkning og andre skadevirkninger. Faktisk har techgigantens egen forskningsenhed samlet en hel værktøjskasse med indgreb, der virker.

Den værktøjskasse går internt under navnet ’break glass measures’ – opkaldt efter det glas, man skal smadre for at trække i nødbremsen eller sætte brandalarmen i gang. De indgreb skal med andre ord KUN bruges i en nødsituation. Hvordan Facebook definerer sådan en, findes der et par hint om i det lækkede materiale.

BBC afslørede i 2019, at Facebook ikke stoppede systematisk handel med husslaver via platformen, selvom man kendte alt til den internt. De lækkede filer viser, at først da Apple truede med at fjerne Facebook fra App Store, blev sagen taget alvorligt og glasset smadret til den akutte nødbremse: Flere hundrede tusinde profiler blev slettet, ip-adresser blev udelukket, og Facebook satte bremser op for opslag om ’gratis pas, flybillet og job’ målrettet kvinder i fattige lande.

I de forkerte hænder er Facebooks målrettede søgninger og push-annoncering som skræddersyede til systematisk misinformation, undertrykkelse af minoriteter, terror og kriminalitet. Men et af de redskaber, der mest effektivt kunne afhjælpe problemerne – et effektivt forbud mod anonyme profiler på Facebook – ligger stadig urørt i nødberedskabet. Det ville helt sikkert også skade forretningen.

MENS CIGARETTERNE kun var skadelige for den enkeltes sundhed, gør Facebooks algoritmer også selve demokratiet sygt.

Det skyldes blandt andet det såkaldte Meaningful Social Interaction-system (MSI), der giver et opslag point efter, hvor mange likes, kommentarer og delinger det får. Opslag med en høj MSI-score pushes aktivt af algoritmen til flere brugere. Det samme sker med opslag, som algoritmen på forhånd spår vil få en høj MSI-score, fordi det ligner andre virale opslag.

Facebooks egen forskning viser, at fake news, hadtale og andre skadelige opslag findes i særligt rigt mål i netop de posts, der ender med at blive delt meget. På den måde er Facebooks algoritme aktivt med til at forurene mediet med netop det indhold, som Mark Zuckerberg ellers siger, han kæmper for at holde nede. Men de samme data kunne bruges til at bremse disse virale opslag, som algoritmen har lært at spotte.

Men det må efterhånden står glasklart, at det ikke bliver Facebook selv, der kommer til at fjerne skadevirkningerne af sine produkter, hvis det samtidig skader forretningen. På den måde er virksomheden ikke spor anderledes end tobaksindustrien.

Og måske bør samfundets tilgang heller ikke være så meget anderledes.

NU HVOR VI VED, hvordan landet ligger, kan vi ikke længere fraskrive os hverken det systemiske eller det individuelle ansvar for at handle på det. Som højesteret sagde til Allan Lykke, der forgæves søgte erstatning hos Skandinavisk Tobakskompagni for sine rygerlunger: De sundhedsskadelige konsekvenser har været kendt vidt og bredt i mange år – så du har også et personligt ansvar.